Inhalt dieses Beitrags

Google hat kürzlich eine bedeutende Aktualisierung in der Google Search Console vorgenommen, indem ein neuer robots.txt-Bericht eingeführt wurde. Dieser Schritt markiert das Ende des bisherigen robots.txt-Testers und stellt eine Weiterentwicklung in der Art und Weise dar, wie Webmaster und SEO-Experten mit der Indexierung ihrer Websites umgehen können. Der neue Bericht bietet detaillierte Einblicke in die robots.txt-Dateien einer Website und ist ein entscheidendes Werkzeug für die Überwachung und Optimierung der Sichtbarkeit von Webseiten in der Google-Suche.

Funktionen des neuen robots.txt-Berichts

Der neu eingeführte robots.txt-Bericht in der Google Search Console bietet umfassende Informationen über die robots.txt-Dateien einer Website. Zu den Hauptmerkmalen gehören:

- Identifikation der robots.txt-Dateien: Der Bericht zeigt die von Google gefundenen robots.txt-Dateien für die 20 wichtigsten Hosts einer Website an.

- Crawl-Daten: Er informiert über das letzte Crawling-Datum dieser Dateien durch Google.

- Warnungen und Fehler: Der Bericht hebt alle aufgetretenen Warnungen oder Fehler hervor, die während des Crawlings der robots.txt-Dateien entstanden sind.

- Notfall-Crawl-Anforderung: Eine neue Funktion ermöglicht es, einen erneuten Crawl einer robots.txt-Datei in Notfällen anzufordern.

Diese Funktionen bieten Webmastern und SEO-Experten eine tiefere Einsicht in die Funktionsweise und Effektivität ihrer robots.txt-Dateien.

Zugriff und Nutzung des robots.txt-Berichts

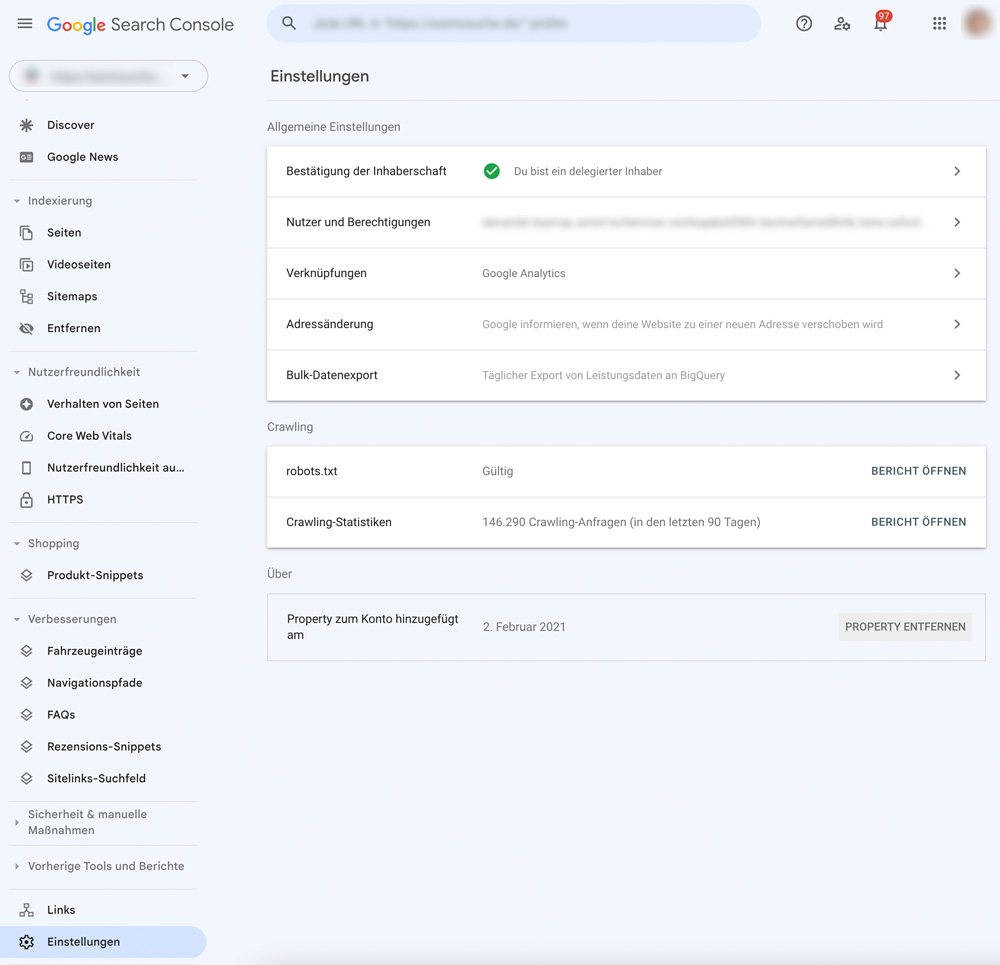

Der Zugriff auf den robots.txt-Bericht erfolgt direkt über die Google Search Console unter dem Menüpunkt „Einstellungen“. Dieser Bericht ist nicht nur ein Instrument zur Fehlerbehebung, sondern auch ein Mittel zur strategischen Planung. Durch die Analyse der Berichtsdaten können Webmaster potenzielle Probleme identifizieren und korrigieren, die die Indexierung und das Crawling ihrer Website beeinträchtigen könnten.

Integration von robots.txt-Informationen in den Seitenindizierungsbericht

Neben dem neuen robots.txt-Bericht hat Google auch relevante Informationen zu robots.txt in den Bericht zur Seitenindizierung integriert. Diese Integration ermöglicht es Nutzern, ein umfassenderes Bild der Indexierung ihrer Seiten zu erhalten und wie die robots.txt-Dateien diese beeinflussen.

Bedeutung des robots.txt-Berichts für SEO

Der neue robots.txt-Bericht ist ein wichtiges Werkzeug für alle, die sich mit der Optimierung von Websites für Suchmaschinen beschäftigen. Er bietet wertvolle Einblicke in mögliche Hindernisse, die die Sichtbarkeit einer Website in den Suchergebnissen beeinträchtigen könnten. Durch regelmäßige Überprüfungen dieses Berichts können Webmaster sicherstellen, dass ihre robots.txt-Richtlinien Google den korrekten Zugriff auf ihre Website ermöglichen, was für eine effektive SEO-Strategie unerlässlich ist.